All’inizio degli anni Ottanta erano pochi gli scienziati che avanzavano proposte sull’applicazione dei modelli quantistici a quelli computazionali già esistenti. Nel 1980 il matematico Yuri Manin pubblicò, in russo, il libro Computable and Uncomputable, aprendo così le porta alla disciplina dell’informatica quantistica. Sempre nello stesso periodo, Paul Benioff scrisse una serie di articoli dove dimostrò, per la prima volta, che realizzare un computer quantistico era teoricamente possibile.

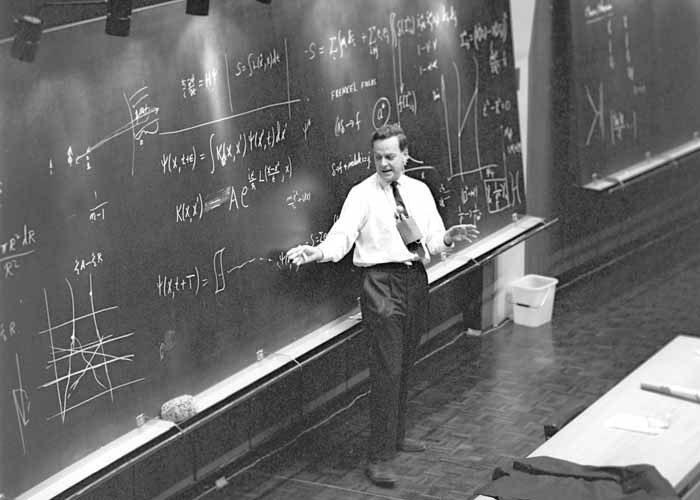

Alla discussione prese parte alla discussione anche l’illustre Richard Feynman. Nel maggio del 1981 durante una conferenza tenne un discorso intitolato Simulating Physics with computer, che divenne successivamente un articolo [1], dove sosteneva che i calcoli richiesti per le simulazioni potevano essere eseguiti in maniera più efficace sfruttando i principi della meccanica quantistica. L’intervento inizia con una domanda: “Che tipo di computer useremo per simulare la fisica?”; che diventa poi: “La fisica può essere simulata da un computer universale?”. Propose allora l’idea di usare un nuovo tipo di computer per simulare i sistemi quantistici dato che quelli classici risultavano del tutto inadeguati per tale scopo. Scrisse infatti:

“C’è la possibilità di farlo con un nuovo tipo di computer, un computer quantistico. Non si tratta di una macchina di Turing, ma di una macchina di tipo diverso. […] È impossibile descrivere i risultati della meccanica quantistica con un dispositivo universale classico.”

Concluse poi in modo memorabile:

“Non sono contento di tutte le analisi fatte che si limitano alla teoria classica, perché la natura non è classica, e se si vuole fare una simulazione della natura è meglio farla sotto il punto di vista della meccanica quantistica e, perbacco, è un problema meraviglioso, perché non sembra così facile.”

Figura 1: Richard Feynman

Qualche rigo fa, nella citazione di Feynman, compare la nozione di “macchina di Turing”., dal matematico Alan Turing che nel 1936 formulò questo potentissimo modello teorico di calcolo. Si compone di un cursore che si muove lungo un nastro, di lunghezza infinita, che è diviso in celle; un insieme di regole, poi, definisce il comportamento del cursore lungo tutta la lunghezza del nastro. Il modello classico di computazione si basa sulla macchina di Turing e le potenzialità di calcolo sono racchiuse nella tesi di Church-Turing, che afferma che ogni procedimento algoritmico, cioè una sequenza ben ordinata di istruzioni eseguite per risolvere un problema, è realizzabile mediante una macchina di Turing [2]. Una definizione formale è:

“Una funzione è calcolabile se e solo se esiste una macchina di Turing che la calcola.”

Qui per funzione calcolabile si intende una funzione parziale definita tra due insiemi che associa a ogni elemento del primo insieme al massimo un elemento del secondo insieme.

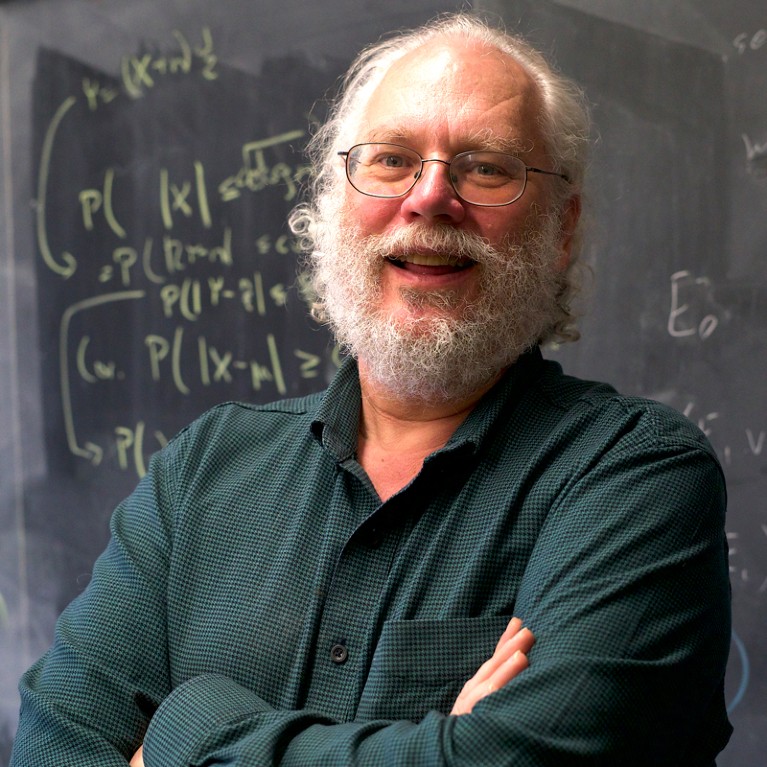

Ma un nuovo approccio necessita un nuovo modello di calcolo ed è per questo che alla computazione quantistica è affiancata la macchina di Turing quantistica, formalizzata per la prima volta da David Deutsch nel 1985. Deutsch espresse una critica alla tesi di Church-Turing che considerava molto vaga rispetto ai principi fisici. Propose, allora, di rendere più concreto il concetto di “funzioni che possono essere considerate naturalmente computabili”, identificando come tali le funzioni che possono essere calcolate da un sistema fisco reale. Ed è in questo modo che la tesi di Church-Turing diventa un principio fisico. Come riporta lui stesso in [3]:

“Posso ora affermare la versione fisica del principio di Church-Turing (CTP):

Ogni sistema fisico finitamente realizzabile può essere perfettamente simulato da un modello di macchina di calcolo universale che opera con mezzi finiti.

Questa formulazione è meglio definita e più fisica di quella di Turing, perché si riferisce esclusivamente a concetti oggettivi come ‘misurazione’, ‘preparazione’ e ‘sistema fisico’, già presenti nella teoria della misura ed evita una terminologia che non si adatta bene alla struttura esistente della fisica.”

Figura 2: David Deutsch.

Quello che è fondamentale osservare è che la macchina di Turing, basata sulla fisica classica, si dimostra totalmente inadeguata, facendo nascere la necessità di una nuova macchina, il computer quantistico. Inizio moduloScrive sempre Deutsch:

“Ogni modello di calcolo esistente è effettivamente classico. Questo significa che specificare completamente un suo stato a ogni istante è equivalente a specificare un insieme di numeri, che in linea di principio sono tutti misurabili. Eppure, secondo la meccanica quantistica, non esistono sistemi fisici con questa proprietà. Il fatto che la fisica classica e la macchina universale di Turing non obbediscano al principio di Church-Turing nella forma forte (CTP) è una delle motivazioni per cercare un modello veramente quantistico.”

Nel proseguo del suo lavoro, presenta un modello quantistico generale di calcolo chiamato computer quantistico universale, capace di simulare perfettamente qualsiasi sistema fisico realizzabile e finito. Questo è da considerare, in base a CTP, una macchina di Turing quantistica. Deutsch introduce tale modello partendo da quello di macchina classica e sostituendo alcune delle componenti ordinarie con elementi quantistici, ad esempio bits in qubits.

È necessario sottolineare che un computer quantistico manipola un tipo di informazione diversa da quella elaborata dai computer classici. John Preskill, uno dei massimi esperti di informazione e computazione quantistica, in [4] dà una elegante definizione di informazione:

“Per un fisico l’informazione è qualcosa che si può codificare, immagazzinare ed elaborare in un sistema attraverso un processo fisico. Poiché fondamentalmente la fisica è meccanica quantistica, l’informazione può essere vista come qualcosa che immagazziniamo ed elaboriamo in uno stato quantistico.”

L’unità fondamentale dell’informazione classica è il bit, che può essere rappresentato da un qualsiasi sistema fisico con due stati distinguibili: 0 e 1. L’equivalente nell’ambito dell’informazione quantistica è il qubit (quantum bit). Lo stato di un qubit si può esprimere come una sovrapposizione di due stati di base, cioè come una combinazione di 0 e 1 contemporaneamente a ognuno dei quali è associata un’ampiezza di probabilità. Questa simultaneità esisterà fino a quando non verrà effettuata l’operazione di misura: quando misuriamo uno dei due stati verrà osservato con la probabilità prescritta. La capacità di una macchina di Turing quantistico di trovarsi contemporaneamente in più stati base è chiamata parallelismo quantistico. In un computer classico non è sufficiente avere un gran numero di processori collegati in parallelo per eseguire calcoli in modo efficiente, è necessario che siano anche tutti adeguatamente sincronizzati. Allo stesso modo, il parallelismo quantistico da solo non basta per raggiungere una computazione quantistica efficace. È importante tenere presente che i risultati ottenuti, nel campo della meccanica quantistica, sono di natura probabilistica. Non possiamo avere la certezza che quando si va a misurare lo stato finale di uscita esso otterrà il risultato corretto che si cerca. Per ovviare a questo problema, è spesso necessario eseguire la misurazione più volte. Per ridurre il numero di prove è importante sviluppare algoritmi quantistici efficienti. Esiste poi un fenomeno chiamato decoerenza: un sistema fisico non è mai perfettamente isolato dall’ambiente circostante e la loro continua interazione fa perdere ai qubit la loro coerenza, cioè la capacità di mantenere simultaneamente più stati e il computer quantistico diventa, in pratica, analogo ad uno classico.

Per costruire un computer quantistico è essenziale utilizzare circuiti per eseguire calcoli. L’approccio circuitale si basa sulla scomposizione di un computer quantistico nelle operazioni base più semplici, note come porte logiche quantistiche. Le porte logiche quantistiche possono essere visualizzate come delle black box (dette oracoli) in cui avvengono operazioni, con un certo numero di linee di input e output che rappresentano i qubit coinvolti, e possono essere combinate per creare una rete che consente le esecuzioni di operazioni più complesse. Questo concetto è alla base dei circuiti quantistici che elaborò Deutsch, generalizzando il modello classico. I circuiti quantistici hanno svolto un ruolo cruciale nello sviluppo dei primi algoritmi quantistici, consentendo le risoluzioni di problemi in modo più efficiente rispetto all’approccio classico. Ad esempio, problemi come la fattorizzazione, considerati intrattabili con i metodi classici (almeno fino ad oggi), sono diventati trattabili in ambito quantistico, dove si risolvono con un guadagno esponenziale rispetto al caso classico. Altri problemi, invece, mostrano guadagni polinomiali, mentre alcuni non beneficiano (ad oggi!) di alcun guadagno.

Il primo esempio di come un computer quantistico possa battere in efficienza un computer classico fu proposto da Deutsch, in collaborazione con Richard Jozsa nel 1992. È stato ideato per risolvere un problema teorico e concettuale molto preciso, noto come “Problema di Deutsch”: un oracolo implementa una particolare funzione (booleana) a n bit e dona come uscita 1 bit (0 o 1); l’obiettivo è quello di determinare se questa funzione restituisce costantemente il valore 0 o se è bilanciata, cioè se restituisce 0 per metà delle possibili combinazioni di input e 1 per l’altra metà. In un computer classico servirebbero un numero esponenziale di valutazioni per risolvere il problema (2^(n-1) + 1) mentre nel caso quantistico si riduce tutto drasticamente: è sufficiente interrogare l’oracolo una sola volta. Il guadagno è evidentemente notevole.

Negli anni immediatamente successivi vennero sviluppati diversi altri logaritmi quantistici significativi, tra cui quello di Bernstein-Vazirani (1993) e quello di Simon (1994). Tuttavia, uno di risultati più significativi fu l’algoritmo proposto dall’informatico statunitense Peter Shor nel 1994 per la fattorizzazione dei numeri interi in numeri primi. Questo algoritmo, se implementato su un adeguato computer quantistico, ha il potenziale per compromettere la sicurezza di sistemi crittografici come lo schema RSA e il protocollo di Diffie-Hellman, entrambi fondamentali per la crittografia a chiave pubblica in uso oggi nella maggioranza dei sistemi di comunicazione sicura. Per dare un rapido sguardo alle nozioni appena introdotte, lo schema RSA si basa sull’assunto che la fattorizzazione di numeri interi di grandi dimensioni sia dal punto di vista computazionale praticamente intrattabile, nel senso che richiederebbe un tempo troppo lungo anche per i supercomputer più potenti, mentre il protocollo Diffie-Hellman consente a due interlocutori di scambiarsi una chiave condivisa e segreta attraverso un canale di comunicazione insicuro.

L’algoritmo di Shor sfrutta strumenti potenti, tra cui la trasformata di Fourier quantistica, per fattorizzare numeri in un tempo che è essenzialmente polinomiale, quando il caso classico richiedeva un tempo esponenziale. La sorpresa che ha suscitato questo risultato all’interno del mondo scientifico è ben riassunta nelle parole dello stesso Shor [5]:

“Penso che diverse persone abbiano trovato sorprendente il risultato di fattorizzazione per diverse ragioni. Gli informatici perché violava il principio di Church-Turing esteso, cioè che tutto ciò che può essere calcolato in modo efficiente (cioè in tempo polinomiale) può essere calcolato in modo efficiente con una macchina di Turing. Se i computer quantistici riescono a fattorizzare numeri grandi in modo efficiente, allora possono fare qualcosa che non si ritiene possibile fare in modo efficiente con una macchina di Turing.

I crittografi hanno trovato sorprendenti i risultati della fattorizzazione perché, se si arrivasse ad avere un computer quantistico, si potrebbero violare gli schemi di crittografia attualmente usati e da cui dipende gran parte della sicurezza di internet.

I fisici trovano l’informatica quantistica sorprendente perché rappresentava un uso nuovo e del tutto inaspettato della meccanica quantistica.”

Figura 3: Peter Shor.

La scoperta di Shor e le implicazioni per la crittografia hanno suscitato un notevole interesse per la computazione quantistica. Tuttavia, alcuni espressero un forte scetticismo riguardo alla possibilità che i computer quantistici possano mai funzionare in modo efficiente. In particolare, Serge Haroche e Jean-Michel Raimond, che conoscevano bene gli effetti della decoerenza sui sistemi quantistici, dissero [6] “che il computer quantistico su larga scala, pur essendo il sogno dell’informatico, è l’incubo dello sperimentatore.” Sempre in [6] i due scrivono:

“Pensiamo che sia necessaria una riflessione critica in un campo che ribolle di emozioni. Riteniamo che l’entusiasmo sia certamente giustificato, ma non necessariamente per le ragioni generalmente citate. Sebbene l’idea del calcolo quantistico implichi una nuova e affascinante fisica che va ben oltre il problema piuttosto banale di una semplice velocità di calcolo, riteniamo che l’esecuzione di calcoli su larga scala rimarrà un sogno impossibile per il futuro- Studiando semplici gate operazionali e l’entanglement di alcuni qubit, i fisici impareranno molto sull’inafferrabile confine tra il mondo classico e quello quantistico e affronteranno alcune delle questioni più profonde sollevate più di mezzo secolo fa dai fondatori della meccanica quantistica. Questa ricerca trae grande beneficio da concetti introdotti dagli informatici, fornendo così un esempio eclatante di fertilizzazione interdisciplinare tra matematica e fisica. Allo stesso tempo, sentiamo la necessità di mettere in guardia dai pericoli di promesse irrealistiche di applicazioni pratiche in un campo in cui sono già state fatte previsioni troppo ottimistiche.”

Altri, invece, ne erano entusiasti. Isaac Chuang, attualmente al Massachusetts Institute of Technology e pioniere nella disciplina, ha detto che “se non fosse stato per i lavori di Peter Shor, l’intero campo di ricerca sarebbe morto”. Infatti, fu ancora una volta Shor a guidare i successivi progressi, scoprendo i primi codici di correzione degli errori quantistici. Tali errori sono causati da fenomeni che generano “rumore” e che interferiscono con la misura dei nostri sistemi quantistici. Le principali fonti di errori includono l’interazione di questi sistemi con l’ambiente (il fenomeno di decoerenza già incontrato), gli errori nelle porte logiche quantistiche dovute a imperfezioni nei componenti, e il rumore termico. Quest’ultimo può essere attenuato lavorando a temperature prossime allo zero assoluto, usando ad esempio dei criostati.

È interessante notare che quando fu proposto l'algoritmo di Shor, molte delle tecnologie sperimentali rilevanti erano già in fase di sviluppo per scopi diversi. Ad esempio, i progressi nella manipolazione di singoli ioni intrappolati erano motivati dalla necessità di sviluppare orologi atomici di maggiore precisione. Nel 1995, Juan Ignacio Cirac e Peter Zoller hanno presentato un'idea rivoluzionaria per la realizzazione di computer quantistici utilizzando ioni intrappolati a basse temperature. In questo approccio, gli ioni intrappolati, che possono essere atomi di itterbio o di altri elementi, vengono ionizzati tramite laser e poi intrappolati in potenziali elettrici per formare una linea di qubit. L'innovativa idea di Cirac e Zoller ha ispirato numerose ricerche sperimentali nel campo della computazione quantistica, contribuendo a creare le fondamenta per le attuali tecnologie basate su qubit di ioni intrappolati.

Oltre alle trappole ioniche, esistono altri metodi per la realizzazione di computer quantistici. Tra questi, i più diffusi comprendono l’utilizzo di qubit basati su superconduttori, qubit topologici e l’approccio del calcolo quantistico adiabatico. La tecnologia basata sui superconduttori fa uso delle giunzioni Josephson, composte da due strati superconduttori separati da una barriera isolante, che sfruttano le proprietà quantistiche delle supercorrenti e delle coppie di elettroni, note come coppie di Cooper, per la creazione di qubit capaci di esistere in una sovrapposizione di stati, rendendo possibile la computazione quantistica. Questa tecnologia è stata adottata da importanti aziende informatiche come Google e IBM.

L’approccio topologico è stato proposto per la prima volta da Alexei Kitaev nel 1997 e si basa sulla topologia, una branca della matematica che studia le proprietà algebriche degli oggetti, che restano invariate quando vengono deformati in modo continuo. Il loro funzionamento sfrutta quasiparticelle chiamate anyon e le intricate operazioni di intreccio (braiding) per realizzare di qubit topologici, che sono resi possibili dall’effetto Hall quantistico frazionario. Questi qubit sono progettati per minimizzare gli errori a livello locale, grazie alle loro proprietà topologiche, pur non eliminando completamente gli errori globali. Questi aspetti ne fanno un promettente candidato nella costruzione di computer quantistici. Tuttavia, è importante notare che al momento le evidenze sperimentali per la loro realizzazione restano oggetto di controversia.

La computazione quantistica adiabatica sfrutta il principio adiabatico della meccanica quantistica, il quale stabilisce che se gli stati di un sistema evolvono lentamente e in modo controllato, il sistema alla fine raggiungerà il suo stato fondamentale, ovvero quello a energia più bassa. Questo principio viene utilizzato per risolvere i problemi di ottimizzazione: si inizia con un sistema quantistico facilmente preparabile in uno stato noto (condizione iniziale) e si va a modificare gradualmente l’operatore che descrive l’energia del sistema (il suo Hamiltoniano). Il vantaggio è che, almeno in teoria, si può utilizzare la computazione quantistica adiabatica per risolvere una vasta gamma di problemi di ottimizzazione. Un esempio concreto di questa tecnologia è stato sviluppato dall’azienda canadese D-Wave, che nel 2011 ha annunciato il computer quantistico D-Wave one con 128 qubit. Nel settembre 2019, l’azienda ha annunciato [7] il loro sistema di quinta generazione che dispone 5.000 qubit.

Anche se, come visto, esiste un metodo standard per la costruzione dei computer quantistici, un importante punto di riferimento nella progettazione e nello sviluppo di computer quantistici affidabili sono i criteri di DiVincenzo. Questi sono una lista di cinque (più due) requisiti per l’implementazione della computazione quantistica presentati dal David DiVincenzo nel suo articolo The Physical Implementation of Quantum Computation del 1997.

Nel panorama attuale, la realizzazione di un computer quantistico si scontra con una moltitudine di sfide ancora aperte. In primo piano emerge la necessità di affrontare con successo la correzione degli errori, che rappresenta una delle sfide più difficili da affrontare. Inoltre, l’incremento del numero di qubit, che al momento è ancora limitato, costituisce una significativa impresa tecnologica. Si aggiunge poi il delicato obiettivo di prolungare al massimo la coerenza dei qubit, garantendo il loro stato di coerenza per un tempo sufficientemente lungo.

Questi rappresentano solo alcuni degli aspetti fondamentali che fanno della realizzazione di un computer quantistico una delle sfide più impegnative dei nostri tempi.

Riferimenti

[1] Richard Feynman. Simulating physics with computers. International Journal of Theoretical Physics (1981)

[2] Carlo Toffalori, Flavio Corradini, Stefano Leonesi, Stefano Mancini. Teoria della computabilità e della complessità. McGraw-Hill (2005)

[3] David Deutsch Quantum Theory, the Chucrch-Turing Principle and the Universal Quantum Computer. Proceedings of the Royal Society A (1985)

[4] John Preskill Quantum computing 40 years later arXiv:2106.10522v3

[5] Panos Charitos Interview with Peter Shor CERN, Newsletter of the EP department (2021)

[6] Serge Haroche e Jean-Michel Raimond Quantum computing: dream or nightmare? Physics Today (1996)

Bibliografia

S. Mancini Quantum Computation Notes

Seiki Akama Elements of Quantum Computing. History, Theories and engineering applications Springer (2015)

Jack D. Hidary Quantum Computing: An Applied Approach Springer (2019)

Francisca Vasconcelos Quantum Computing at MIT: The Past, Present, And Future of the Second Revolution in Computing arXiv:2002.05559v2 (2022)